우리 팀의 능력자(!) 분께서 또 찾아주신 모델!!

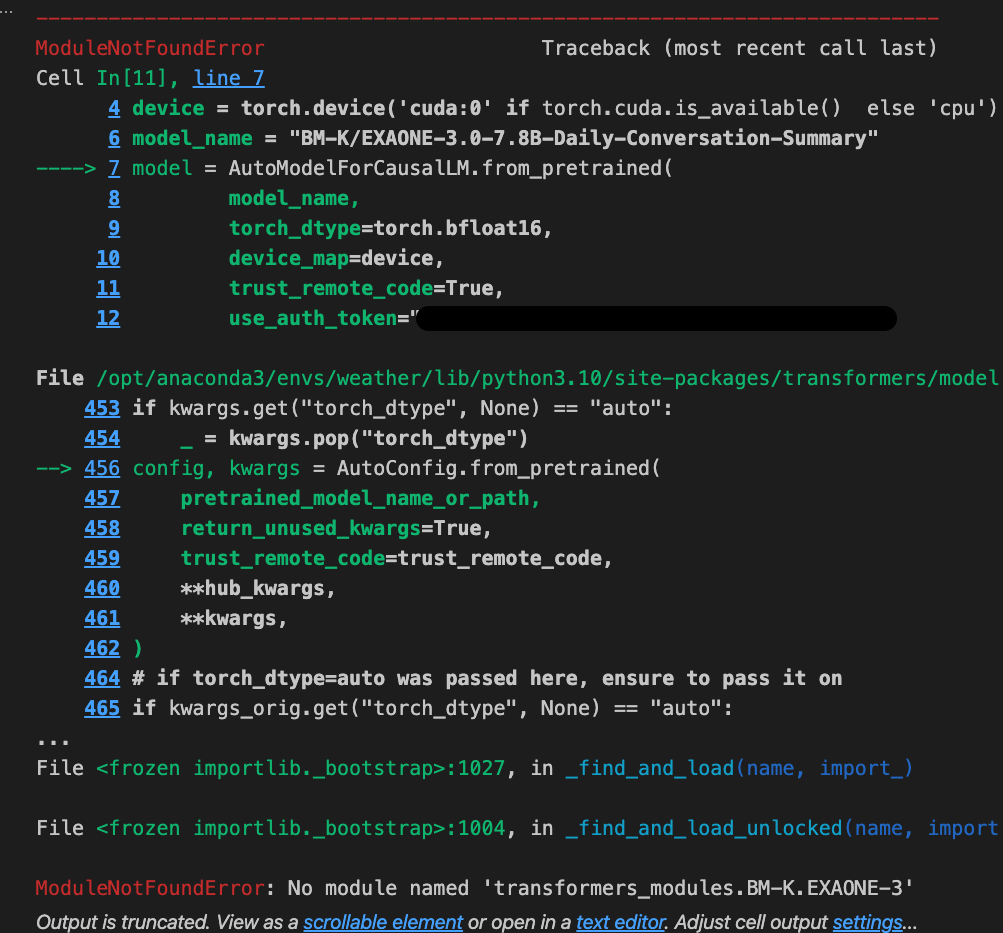

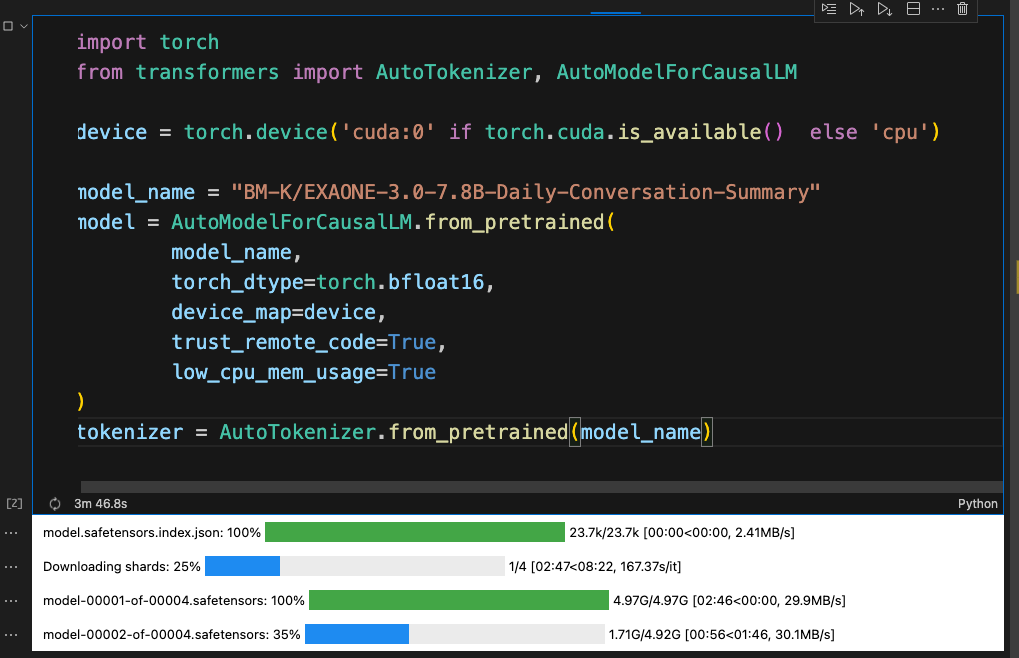

EXAONE 모델을 대화문 요약으로 파인튜닝한 모델이 있어서, 이 모델로 인퍼런스 해볼라고 모델 로드하는데 자꾸 막혀서 계속 헤매다가...

아 이거 어찌나 짜증나던지.. 클로드한테 물어봐도 자꾸 똑같은 말만 반복하고 access token 을 설정하라는둥, 모델 프라이빗에 있는거 아니냐는둥.. 도돌이표같은 얘기만 계속 하면서 시간을 버림ㅠ 그러다가 원래 모델인 EXAONE-3.0-7.8B-Instruct 페이지를 보다가 뒤늦게 발견했다.

"We recommend to use transformers v4.41 or later."

트랜스포버 버전을 최신 버전으로 업그레이드하고 액셀러레이터인가? 그거 업데이트하니까 된다..!!!

하하하하 ㅠㅠㅠ이 창에서 얼마나 헤맸는지ㅠㅠㅠ 정답은 의외로 너무 사소했던 버전이슈... 앞으로는 버전을 잘 체크하자

https://huggingface.co/BM-K/EXAONE-3.0-7.8B-Daily-Conversation-Summary

BM-K/EXAONE-3.0-7.8B-Daily-Conversation-Summary · Hugging Face

2024-NIKL-DCS 국립국어원 AI 말평 일상 대화 요약 '모델뒤에사람있어요' 팀 제안된 모델은 사전 훈련된 언어 모델 EXAONE을 기반으로 파인 튜닝되었으며, 특정 지식이나 기술을 습득하도록 설계되었

huggingface.co

그리고 어제부터 계속 헤매고 있던.. 아직 정답을 찾지 못한 모델의 이슈도 하나 있다.

T5 모델 중에 한국어로 요약 태스크를 사전학습한 모델인데,

자꾸 데이터 내용 중에 들어간

이 정보를 이따구로 '사시는데'로 만들어버린다;

대체 왜... 이거 모델 구조가 좀 달라서 기존 베이스라인 코드에서 이것저것 만졌는데 뭔가가 잘못된 것 같다..

인코딩 디코딩에 들어가는 스페셜 토큰 제대로 들어가는지 확인했는데도 안됨;

'공부방 > Upstage AI Lab 4기' 카테고리의 다른 글

| [NLP] VRAM이 딸려서 모델이 안돌아갈때 할 수 있는 방법들 (0) | 2024.11.28 |

|---|---|

| [NLP] EXAONE 모델 가져다가 추론만 시키기 (2) | 2024.11.27 |

| GPU 상세 스펙 알아두고, 메모리 램 관리하기 (0) | 2024.11.26 |

| [NLP] 화자가 몇 명인지 정보를 주면 좋을까? (0) | 2024.11.20 |

| [NLP] 대화의 턴수와 주요 발화자를 토큰으로 추가해보자 (1) | 2024.11.19 |